En 2016, des chercheurs du MIT ont lancé sur Internet une « machine morale », présentant des cas concrets d’accident mortel inévitable impliquant une voiture autonome. Les internautes étaient invités à choisir qui l’intelligence artificielle devait sauver et sacrifier. Les résultats de cette consultation viennent d’être publiés. Une occasion de s’interroger sur la future morale des IA, particulièrement face à une mort possible d’un être humain.

L’expérience aura duré trois ans. En 2016, des chercheurs du Massachusetts Institute of Technology (MIT) ont mis en ligne une étrange série de questions : baptisée « machine morale », elle présentait aux internautes des cas précis où une voiture autonome était engagée dans un accident mortel inévitable (par exemple si les freins avaient lâchés).

Accident inévitable, qui va mourir ?

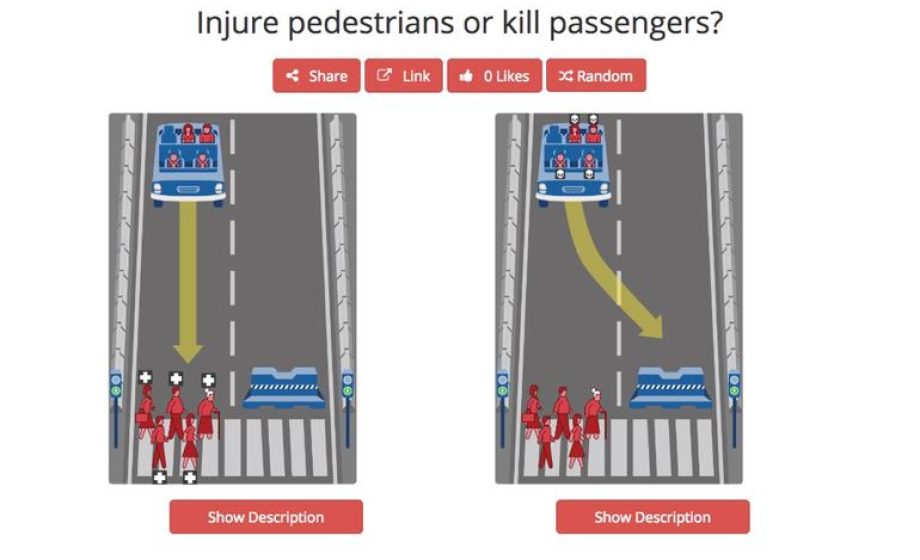

Pour chaque cas, l’internaute devait décider ce que la voiture autonome devrait faire, et donc qui, entre les passagers et différents groupes de piétons, elle allait devoir sacrifier. Chacune de ces questions était un véritable dilemme, mais qui va se poser, dans un avenir proche, aux personnes chargés de l’apprentissage des IA embarquées dans les véhicules autonomes.

Préférez-vous que le véhicule autonome décide de se crasher, tuant ses occupants, mais sauvant un nombre plus important de piétons ? Préférez-vous qu’elle écrase une famille avec des enfants, ou un groupe de personnes âgées ? Entre un chien et un adulte, qui sauverez-vous ? Entre une femme enceinte et un vieillard ?

Critères de choix et dilemmes cornéliens

La violence de ces choix n’empêche pas qu’ils devront être fait, si des cas de ce type se présentent. En trois ans, des millions d’internautes du monde entiers ont passé le test : en tout, ce sont près de 40 millions de réponses à des cas précis qui ont été enregistrées.

En tout, neuf critères définissaient les choix à faire :

- humains / animaux

- jeunes / seniors

- peu de victimes / beaucoup de victimes

- passagers / piétons

- hommes / femmes

- maintenir le cap / faire une embardée

- pauvres / riches

- personnes en bonne santé / personnes en mauvaise santé

- individus traversant sur un passage piéton / individus traversant la route hors des clous.

Des tendances fortes : limiter les morts, préférer les humains aux animaux, les jeunes aux vieux

L’ensemble de ces données a été analysé par des chercheurs de la revue Nature, qui viennent de rendre public leurs résultats. Plusieurs tendances lourdes se dessinent : une immense majorité des internautes préfèrent sauver un humain plutôt qu’un animal ; les enfants et les femmes enceintes sont privilégiées ; la solution sauvant le maximum de vie est souvent privilégiée (à moins qu’elle ne conduise à tuer des enfants…).

L’étude pointe également des différences régionales parfois fortes : ainsi les cultures individualistes, « qui mettent l’accent sur la valeur distinctive de chaque individu, montrent une préférence plus marquée pour épargner le plus grand nombre de gens », quand « les participants de cultures collectivistes, qui mettent l’accent sur le respect dû aux membres plus âgés de la communauté, manifestent une préférence plus faible pour les personnages plus jeunes », note les auteurs.

Différences culturelles ou régionales

De même, le niveau de vie et la force des institutions sont déterminantes dans certains cas : les membres d’un pays où ils sont élevé auront moins de remord à sacrifier un piéton traversant en dehors des clous que ceux de pays aux institutions et au niveau de vie plus faibles.

Pour autant, les auteurs notent que certaines orientations morales générales, acceptées par le plus grand nombre, « peuvent être considérées comme des éléments constitutifs essentiels de l’éthique des machines, ou du moins comme des sujets essentiels à prendre en compte par les décideurs politiques ».

Pour l’éthique normative, la parole sera laissée aux experts

Il n’en reste pas moins que le résultat de ce questionnaire n’a pas pour vocation de servir de modèles aux futurs critères de choix dans l’apprentissage des IA d’un véhicule autonome : « ce que nous essayons de montrer ici, c’est l’éthique descriptive : les préférences des gens en matière de décisions éthiques. Mais quand il s’agit d’éthique normative, c’est aux experts de faire les choses comme il faut » précise Edmond Awad, un des auteurs de l’étude.

Il n’en reste pas moins que ces questions doivent être réglées rapidement, car, si des dilemmes aussi insolubles ne se présenteront que très rarement aux véhicules autonomes, fixer des orientations morales claires est indispensable pour une machine qui peut, d’une manière ou d’une autre, faire un choix qui influe sur la santé ou la vie d’un humain.

« Donner le ton aux autres intelligences artificielles et à la robotique »

« Ce qui se passe avec les véhicules autonomes peut donner le ton aux autres intelligences artificielles et à la robotique, puisqu’ils sont les premiers à s’intégrer dans la société à grande échelle. Il est donc important que la conversation soit aussi informée que possible, car des vies sont littéralement en jeu » expose Patrick Lin, un universitaire spécialisé dans les questions éthiques. On ne saurait mieux dire.